Software-Entwicklung: Frag doch mal die anderen - Crowd-Computing für kreative Aufgabe

- Typ: Praktikum

- Semester: WS 14/15

-

Zeit:

PSE Auftaktveranstaltung

Mittwoch, 29.10.2014, 15:45-17:15 Uhr,

Fasanengarten-Hörsaal (Geb. 50.35)Kick-Off-Meeting

Freitag, 07.11.2014, 09:00 Uhr,

Raum 348 (3. Stock), Geb. 50.34

weitere Termine erfolgen nach Absprache - Dozent:

- SWS: 4

- LVNr.: 2400070

Motivation

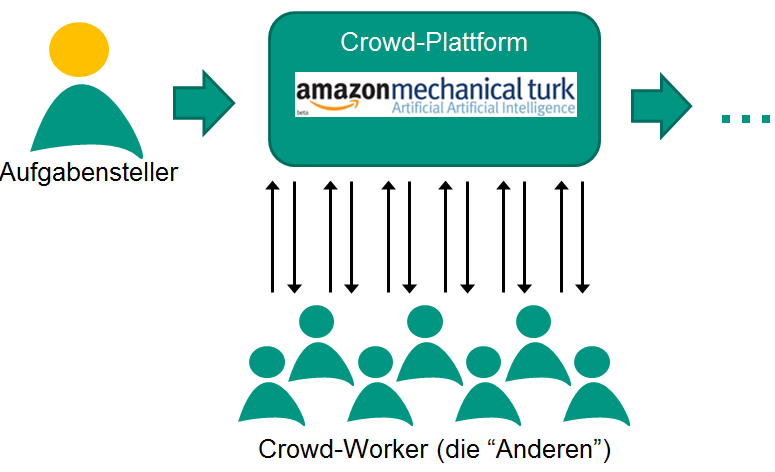

Das Ziel unserer Forschung ist es zu untersuchen, ob und unter welchen Umständen Crowd-Worker zur Generierung von kreativen und lustigen Inhalten eingesetzt werden können. Aufgaben können dabei beispielweise das Schreiben eines lustigen Spruches für Sitcoms oder das Kreieren eines neuen Fotowitzes sein. Allerdings kann der Aufgabensteller nicht sicher sein, dass die Crowd-Worker auch Inhalt in der gewünschten Qualität liefern. Daher müssen geeignete Qualitätssicherungsverfahren umgesetzt werden wie beispielsweise eine Bewertung der abgelieferten Inhalte durch weitere Crowd-Worker.

Aufgaben

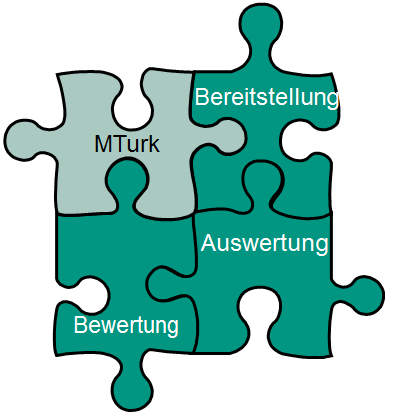

Der erste Schritt ist die Bereitstellung der Aufgabe auf der Crowd-Plattform MTurk. Dazu muss eine Aufgabenstellung und eine Reihe von Parametern wie die Höhe der Bezahlung festgelegt, eine entsprechende Webseite generiert und anschließend als sogenannter externer HIT an die Crowd-Plattform übergeben werden. Anschließend haben die Crowd-Worker die Möglichkeit, die Aufgabe zu bearbeiten und ihre Antworten einzusenden. Um sicherzustellen, dass die Crowd-Worker möglichst einfallsreiche und lustige Antworten einsenden, sollen die eingegangenen Antworten durch andere Crowd-Worker bewertet werden. Zur Bewertung der Antworten soll das zu erstellende System automatisch neue Bewertungsaufgaben für die Crowd-Worker erstellen und ebenfalls auf der Crowd-Plattform veröffentlichen. Wenn die gewünschte Anzahl an Antworten eingegangen ist und diese auch die gewünschte Qualität haben, soll abschließend die Aufgabe ausgewertet werden. Zur Auswertung gehören dabei unter anderem die Bezahlung der Crowd-Worker nach vorher festgelegten Bedingungen und die Erstellung einfacher Statistiken.

Die umgesetzte Software-Infrastruktur wollen wir dann bei der Durchführung von Forschungsexperimenten mit verschiedenen Parametern und Bedingungen einsetzen. Daher steht die Entwicklung einer möglichst modular gestalteten Lösung mit hoher Flexibilität und einfacher Erweiterbarkeit im Vordergrund. Ein graphisches User-Interface für den Aufgabensteller ist optional.